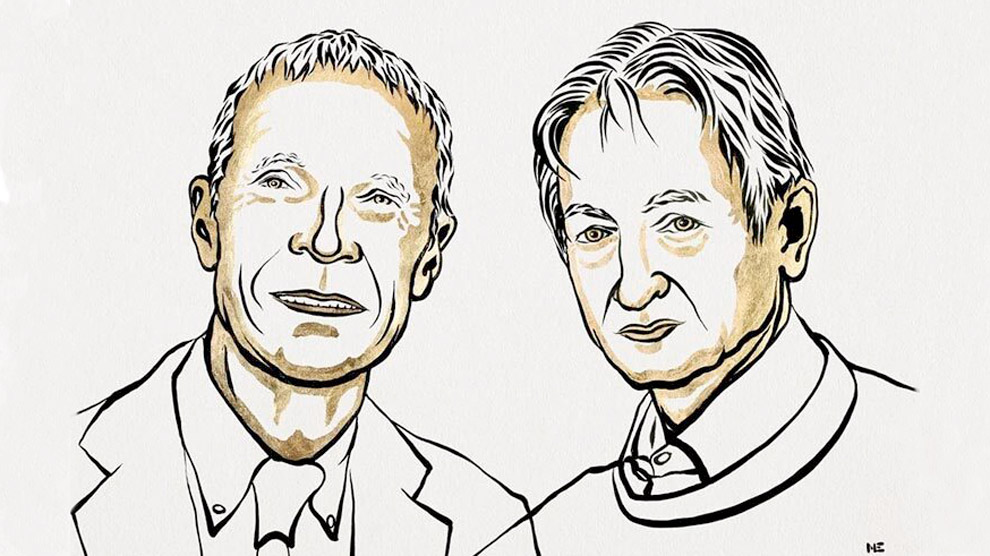

Premio Nobel de Física 2024

Distinguen hallazgos fundacionales para el aprendizaje automático

John Hopfield creó las redes que ahora llevan su nombre y utilizó la física estadística para demostrar que un algoritmo de este tipo podía memorizar información. No obstante, entrenar estos modelos resultaba muy complicado.

En los años 80 del siglo pasado, Geoffrey Hinton, junto con otros investigadores como Yoshua Bengio, Yann LeCun y Jürgen Schmidhuber desarrollaron una versión moderna más simple y eficiente. Inventó el método moderno de entrenamiento de redes neuronales, conocido como backpropagation, que permitió superar las limitaciones de los modelos anteriores. Esta tecnología evolucionó en muchos modelos especializados dentro de los cuales se encuentran los transformers, lo que es la base del ChatGPT, aclaró Huziel Sauceda.

Esas contribuciones demostraron que las redes neuronales podían memorizar y aprender patrones ocultos en los datos, añadió el académico universitario.

Primeros intentos

Los primeros intentos de neuronas artificiales se presentaron en la década de los 40, inspirada en el cerebro humano, en los que las neuronas están unidas por interconexiones de alta complejidad.

A finales de los 50 del siglo XX, se creó por primera vez una versión para programar en computadoras analógicas, aunque únicamente manejaba una neurona. A pesar de estos avances, modelos como el perceptrón de Frank Rosenblatt, propuesto en 1958, no pudieron resolver muchos problemas, lo que llevó al primer “invierno de la IA”.

Pero en los 80, los modelos mejoraron con más neuronas y mejores algoritmos, como el backpropagation de Hinton.

Cuando se conectan muchas neuronas de una forma particular, se llega a la tecnología de Hinton y Hopfield. No obstante, si se conectan de otra manera, se crea otro tipo de arquitectura especializada.

La conexión entre neuronas se conoce como arquitectura de red neuronal y permite resolver problemas específicos. Por ejemplo, para clasificar imágenes se usa una arquitectura llamada redes convolucionales, especializada en este tipo de análisis.

Aunque estas arquitecturas pueden servir para otras tareas, son particularmente buenas en sus áreas de enfoque, añadió Huziel Sauceda. Un ejemplo es el uso de redes neuronales para analizar series de tiempo, como en la predicción del clima.

Otro tipo de conexión, como los transformers, se usa para reconocer una misma palabra en diferentes contextos y asignarle significado según el entorno. Por ejemplo, “el banco de peces en el océano” y “el banco en la calle tal está abierto”. Esta arquitectura, creada en 2017, permitió crear modelos que analizan las frases de manera global y muy eficiente.

¿Ciencia ficción o realidad?

Gracias a la ciencia ficción, muchas personas se preguntan: ¿qué tan cerca estamos de crear una IA que tome el control del mundo? Huziel Sauceda mencionó que la humanidad está muy lejos de desarrollar una tecnología todopoderosa.

Por ejemplo, una computadora es un procesador que recibe órdenes a través de dispositivos como el mouse. Para hacer algo, necesita un input (una orden), ya sea mover el mouse o teclear algo, pero si se deja la máquina sin tocar, no hará nada.

Esto es diferente en las personas, cuyo cerebro permanece activo las 24 horas, pensando en múltiples temas. En cambio, con una máquina interactuamos y, al dejarla, queda inactiva.

Sin embargo, se han hecho grandes avances en ciertos modelos, en los que se han especializado profundamente. Algo relevante es que “no entendemos por completo lo que estamos haciendo; sabemos crear modelos y entrenarlos para que aprendan, pero no por qué funcionan”.

Una controversia

Otorgar el Premio Nobel de Física por las bases de la IA podría generar controversia, pues pudiera entenderse como un reconocimiento a una investigación en el área computacional, señaló el investigador.

Ya hay un galardón equivalente en ciencias computacionales, el Premio Turing, otorgado a contribuciones en computación e inteligencia artificial. De hecho, en 2018 este reconocimiento fue otorgado a Geoffrey Hinton junto con Yoshua Bengio y Yann LeCun.

Sin embargo, Huziel Sauceda opina que Hopfield y Hinton merecen un reconocimiento más amplio, como el Premio Nobel de Física, ya que sus trabajos se fundamentan plenamente en la física estadística. Ambos tomaron ideas de esta rama para demostrar que un sistema estadístico, como los espines en sistemas magnéticos, podía almacenar información. Ésta es una razón clave que justifica la decisión del comité Nobel.